Avec l’IA générative, les évaluations de compétences deviennent enfin formatives, levant un frein à l'épanouissement professionnel et ôtant une sérieuse épine du pied de la communauté RH.

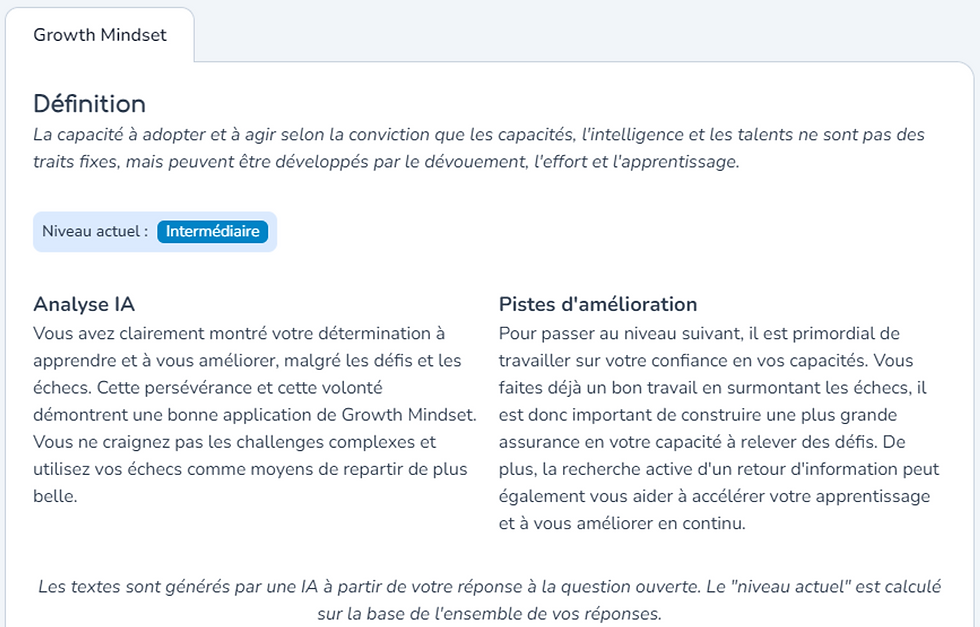

Figure 1 : Exemple de synthèse et d'analyse d'une évaluation de compétence par l'IA générative. Compétence étudiée ici : l'aptitude à l'IA générative, décomposée en plusieurs facettes.

Dans un monde où les évaluations de compétences sont trop souvent réductrices et sommatives, classant les individus dans des catégories rigides plutôt que de favoriser leur développement, le secteur des Ressources Humaines fait face à un sérieux défi. Non seulement cette pratique limite la perception des potentialités individuelles, mais elle freine également l'évolution professionnelle en se concentrant sur le passé et non sur le potentiel futur. Or il existe une solution : c’est une petite révolution offerte par l'utilisation de l'IA générative, promettant une objectivité sans précédent, une performance accrue, et une adaptabilité en parfaite adéquation avec les besoins actuels. En adoptant une approche formative, l'IA générative transforme les évaluations en outils dynamiques de développement personnel, mettant en lumière non seulement où l'individu se trouve aujourd'hui, mais surtout, où il peut se diriger demain.

Des évaluations plus puissantes à tous égards

L'utilisation de l'IA générative dans les évaluations de compétences leur confère une puissance sans précédent en termes d’objectivité, de performance et d’adaptabilité. La technologie s'applique indifféremment aux évaluations de compétences techniques ou humaines.

Plus objectives

Les méthodes traditionnelles d'évaluation, telles que les autoévaluations et les évaluations à 360 degrés, bien qu'utiles, sont souvent teintées de subjectivité et peuvent être influencées par divers biais personnels et interpersonnels. En revanche, les évaluations réalisées par l'IA générative promettent une objectivité accrue, car elles se fondent sur des données factuelles et des performances réelles plutôt que sur des perceptions. A titre d’exemple, pour mesurer les compétences en gestion de projet, l'outil peut analyser des preuves concrètes de gestion de projets réussis, telles que les délais respectés, le budget géré et les retours d'équipe, offrant ainsi une évaluation objective de la compétence.

L'intérêt des écarts de perception entre l'autoévaluation, l'évaluation par les pairs et celle réalisée par l'IA est particulièrement précieux. Il met en lumière les différences entre la perception de soi, la perception des autres et les performances réelles, offrant ainsi des pistes de développement personnel en matière de communication et de leadership.

Plus performantes

La validité et la fiabilité sont au cœur des évaluations basées sur l'IA générative. Ces outils sont conçus pour couvrir exhaustivement le spectre de la compétence évaluée, garantissant ainsi que tous les aspects, même les plus nuancés, sont pris en compte. Ainsi, en s'assurant que l'évaluation englobe chaque facette d'une compétence, l'IA garantit que les résultats reflètent fidèlement les capacités réelles de l'individu et donc que l’évaluation est valide.

L'approche multi-IA, où une batterie de mesures et / ou de modèles contribuent à l'évaluation, augmente la fiabilité en comparaison avec les méthodes traditionnelles qui dépendent souvent d'un seul évaluateur. Cela assure non seulement une répétabilité des résultats malgré la nature non déterministe de l'IA mais aussi une impartialité accrue. Ces avancées technologiques s'ajoutent à la méthodologie de triangulation des compétences déjà mise en œuvre par certaines plateformes, comme Elendi, enrichissant ainsi l'évaluation par une perspective multicouche.

Plus adaptatives

Enfin, la capacité des évaluations basées sur l'IA à s'adapter tant au profil de l'évalué qu'aux exigences changeantes des compétences constitue un autre de leurs atouts majeurs.

L'IA peut ajuster le niveau de difficulté des questions ou proposer des scénarios de jugement situationnel qui correspondent au contexte professionnel et au niveau d'expérience de l'évalué. Ainsi, un jeune manager se verra proposer des situations adaptées à son expérience, tandis qu'un cadre supérieur sera confronté à des dilemmes plus complexes et stratégiques.

Compte tenu de l'évolution rapide des besoins en compétences dans de nombreux secteurs, l'IA générative permet une mise à jour dynamique des critères d'évaluation pour refléter les compétences les plus récentes et pertinentes. Par exemple, dans le domaine du marketing digital, l'IA ajuste les évaluations pour intégrer les dernières tendances et outils, assurant ainsi que les compétences évaluées restent au diapason des pratiques actuelles du secteur.

L’intégration parfaite de l'évaluation au développement

L'une des avancées les plus significatives permises par l'IA générative est sa capacité à transformer les évaluations en véritables tremplins pour le développement personnel et professionnel. L’évaluation cesse alors d’être uniquement la sanction d’un niveau atteint ponctuellement pour devenir un outil de développement à part entière : on l’appelle ainsi évaluation formative.

L’écart au niveau supérieur

La puissance de l'IA générative réside dans sa capacité à diagnostiquer finement les écarts entre les compétences actuelles et celles requises pour atteindre le niveau supérieur. Plus qu'une simple identification des lacunes, l'IA générative déploie une analyse approfondie pour déceler des pistes de progression personnalisées, émettant des recommandations précises et sur-mesure.

Figure 2 : Exemple d'analyse et de recommandation d'apprentissage généré par l'IA lors d'une évaluation de Growth Mindset

Recommandations de formation

Dans la continuité de l’évaluation, l'IA enrichit considérablement le parcours d'apprentissage en proposant des contenus spécialement sélectionnés ou conçus pour répondre aux besoins individuels. Ces ressources, qu'elles soient identifiées parmi une vaste bibliothèque existante ou générées de manière innovante par l'IA, sont parfaitement alignées avec les objectifs de développement de chaque apprenant, rendant l’expérience plus pertinente et engageante encore.

Evaluations continues

L'intégration d'évaluations continues tout au long du processus d'apprentissage constitue un autre pilier fondamental de cette approche. Ces moments d'évaluation réguliers fournissent un retour détaillé et constructif, essentiel pour guider les apprenants dans leur progression. Cette stratégie permet d'ajuster les stratégies individuelles d'apprentissage en fonction des résultats obtenus, assurant ainsi une amélioration constante des compétences.

Mesure d’impact

Enfin, la capacité à réaliser plus facilement des évaluations à des moments stratégiques du parcours d'apprentissage offre une vue précise de l'efficacité des programmes de développement. Cela permet aux responsables L&D de mesurer l'impact réel des initiatives de formation, tant au niveau individuel que collectif, et d'ajuster les stratégies en conséquence pour maximiser le retour sur investissement.

Toute la force de l'IA sans les inconvénients d’un modèle particulier

L'intégration de l'IA générative dans l'évaluation des compétences soulève notamment la question de la dépendance à des modèles spécifiques.

Risques du modèle spécifique

Quels problèmes cela pourrait-il poser ? Le propre de l’IA générative est de générer allègrement du contenu, et elle le fait avec une assurance sans faille qui peut légitimer à tort le contenu. Or tout modèle d’IA générative (LLM) est construit à partir d’un certain nombre de “choix éditoriaux” : certains modèles seront par exemple de culture plutôt anglo-saxonne, ou plutôt européenne, ou plutôt chinoise ; ils intègreront des comportements habituels, acceptables ou interdits au sein de certaines populations ; ils auront une tolérance plus ou moins affirmée à l’insolence ou au politiquement correct ; ils renfermeront toute une série de biais volontaires ou accidentels. Leurs parti-pris se reflèteront nécessairement dans les évaluations générées. De plus, ces modèles évoluent constamment, et pas forcément de manière transparente. Le risque existe alors que l’évaluation soit perturbée au gré des transformations du modèle. Pire encore, la dépendance totale au modèle pourrait influencer les évaluations à l’insu de tous.

Une approche combinée

Pour contourner ce défi, une approche combinée s'avère efficace : intégrer une couche de savoir propriétaire à un modèle de langage générique permet de bénéficier de la puissance de l'IA tout en s'affranchissant des biais potentiels et des limites inhérentes à un seul modèle. C’est la couche de savoir qui renferme toute l’expertise psychométrique, par exemple des référentiels de compétence de grande qualité, ou encore les questions précises à poser pour garantir la validité d’une évaluation. C’est donc cette couche de savoir qui constitue le socle de l’évaluation, solide et à l’abri des parti-pris du modèle de langage. Celui-ci peut en revanche déployer toute sa puissance pour analyser le contenu à évaluer, à la lumière de la référence incluse dans la couche de savoir.

Figure 3 : Aperçu de l'approche combinée d'Elendi

On l’aura compris : c’est un dosage savant d’expertise en psychométrie et en intelligence artificielle générative qui permet la mise en œuvre des évaluations le plus avancées. Ces évaluations sont à la fois performantes, responsables et flexibles. Elles sont de plus pleinement intégrées au parcours de développement personnel et professionnel de l’individu évalué.

Vous aussi souhaitez en faire bénéficier votre organisation ?

Comments